成为哈基米大王|打野Github的Gemini Key并通过GPT-Load建立大模型Key池

由于各家AI IDE逐步收紧的用户政策,低成本的使用AI开发似乎成为了奢望。

不过并非毫无办法,我们可以利用Github泄露的Gemini-Key搭建负载均衡的Key池。

搭建完后可以用于编码,日常搜索,或者拿来角色扮演也行(:

什么是打野?

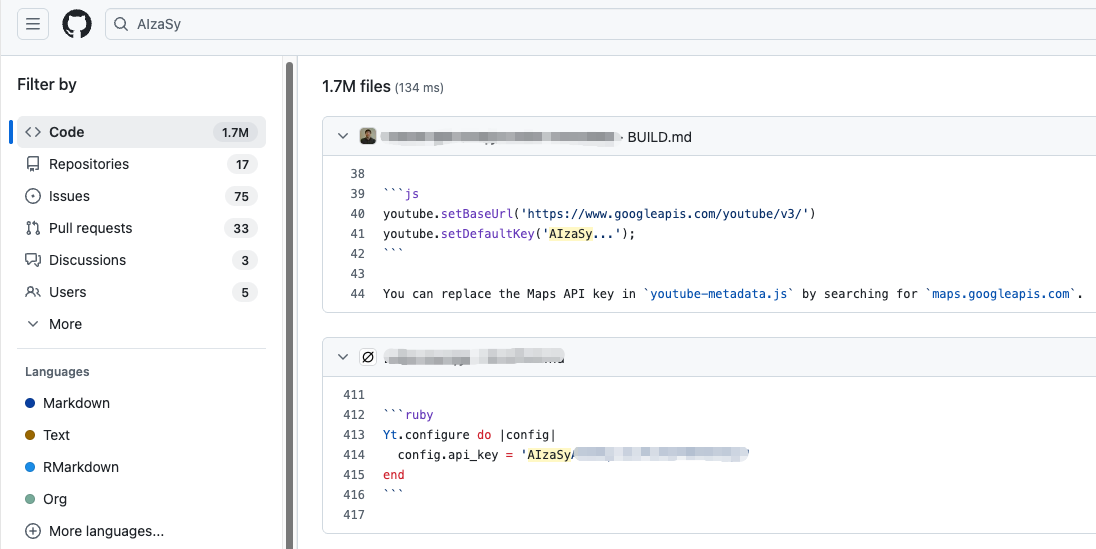

通过搜索代码仓库,博客等Web资源,发现被意外上传的API Key。

拿GitHub来说,不少人上传代码时会把对接大语言模型的Key放在环境变量或者写死在代码里

我们随便搜索Gemini Key的前缀「AIzaSy」就能发现不少。

这些Key有能用的,也有失效的,我们的目的是尽可能将其一网打尽,通过不断轮询这些泄露的Key建立一个负载均衡的Key池。

和谷歌不同,OpenAI和Claude会直接封禁泄露在仓库中的Key,感觉是运营方式上稍有不同的原因,Gemini的Key是有免费配额的,其它两家官方的渠道只能直接购买额度。

如果你想知道更多的低成本AI编码的方法,请前往总结或者与我讨论

开始部署

哈基米大王

需要Docker环境,可以把它放在家里的路由器,自己的电脑,或者有公网的云主机上,自行了解Docker Compose使用方法

需要有可以接入API的LLM对话平台,推荐CherryStudio

两个工具的仓库都有详细的部署说明,不过我说重点

打野机hajimi-king

项目地址:GakkiNoOne/hajimi-king: 人人都是哈基米大王 感谢作者~

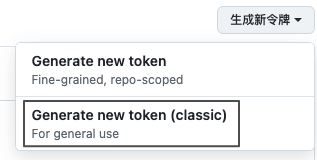

获得Github Token

访问 GitHub Settings > Tokens 生成经典令牌

选择public_repo 权限后保存记下令牌

令牌越多越好,一个令牌最多查找规则内的1000条结果,且有速度限制,最终查找到多少Key很大程度取决于有多少Token

我一个小时200-300Key左右,不过会因为Token的限制而停止查找。

使用Docker Compose部署项目

services:

hajimi-king:

image: ghcr.io/gakkinoone/hajimi-king:latest

container_name: hajimi-king

restart: unless-stopped

environment:

# 必填:GitHub访问令牌

- GITHUB_TOKENS=令牌1,令牌2(可选),令牌(可选)++

# 可选配置,模型选择flash-lite即可,不影响后续使用模型

- HAJIMI_CHECK_MODEL=gemini-2.5-flash-lite

- QUERIES_FILE=queries.txt

# - 环境变量在这添加,一行一个

volumes:

- ./data:/app/data

working_dir: /app创建docker-compose.yml 将文本复制并修改,你只需要添加前一步的Github令牌,改变模型即可,根据仓库教程启动。

启动服务

# 创建数据目录和查询文件

mkdir -p data

echo "AIzaSy in:file" > data/queries.txt

# 启动服务

docker-compose up -d

# 查看日志

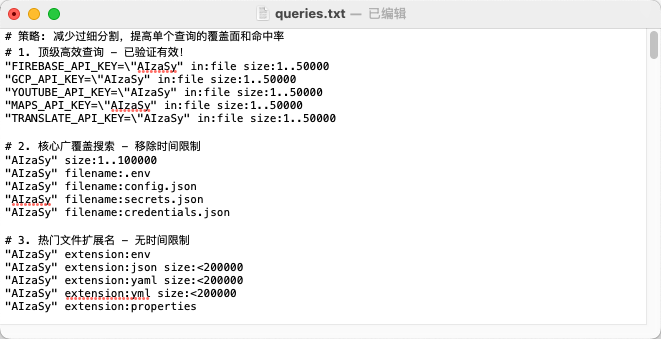

docker-compose logs -f启动成功后修改目录中的queries.txt

这是用来匹配Key的规则,在Token少的情况下需要通过小而精的查找节省资源,可以把日志搬给AI优化你的规则,重启生效

搜索语法参考:GitHub Code Search Syntax

区别找到的Key

有效的密钥:keys/keys_valid_

速率限制的密钥:keys/key_429_

发给其它项目的密钥:keys/keys_send_

429的Key在恢复后也是能用的,有效的Key在每日额度用完后也会429

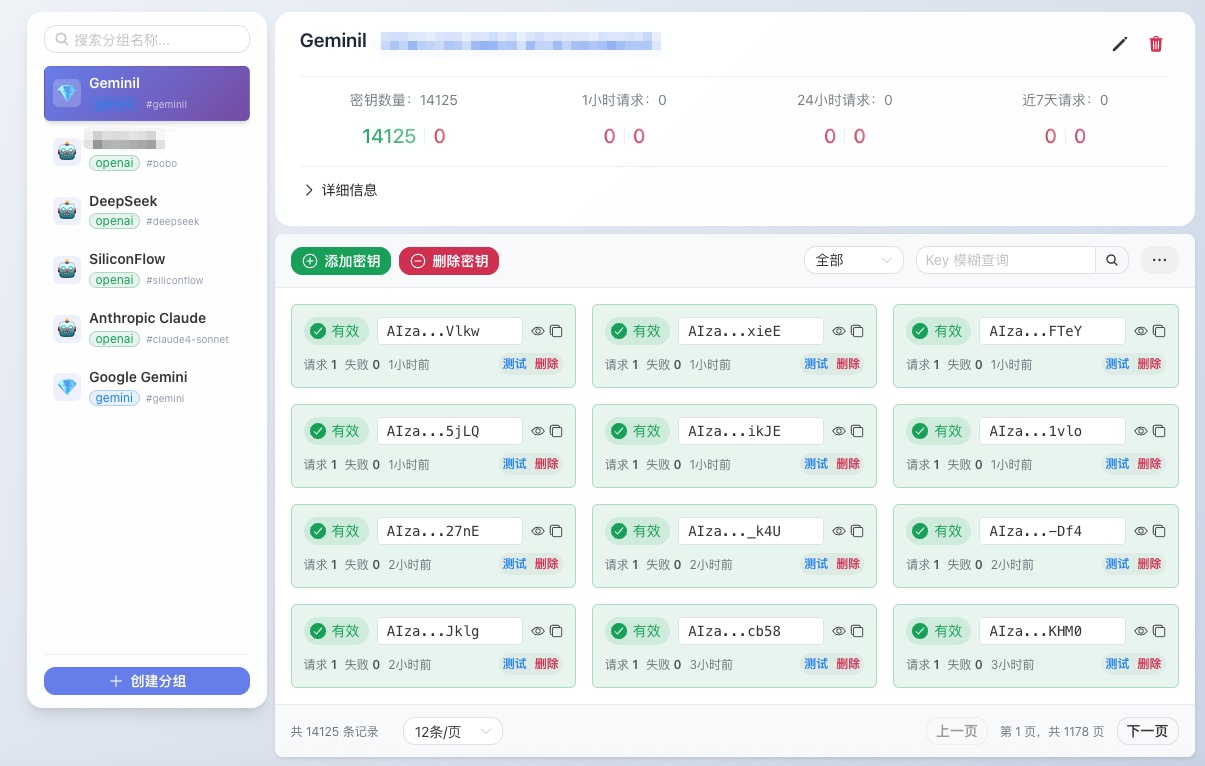

GPT-Load

使用GPT-Load管理你的大量Key,

仓库:tbphp/gpt-load: 智能密钥轮询的多渠道 AI 代理。 Multi-channel AI proxy with intelligent key rotation. 感谢作者

打野来的Key良莠不齐,有效和无效的Key混杂在一起,我们需要一个不断轮询Key状态的池子,再通过这个池子调用大模型,降低每次调用的错误率

2200Key池24h错误率大概在1%左右,可以将不同质量的Key分开。

GPT-Load有完善的文档,部署教程等,详细请查看官方文档。

将并发验证数加大可以大幅加速轮询速度。

GPT-Load接入hajimi-king,实现自动化管理密钥

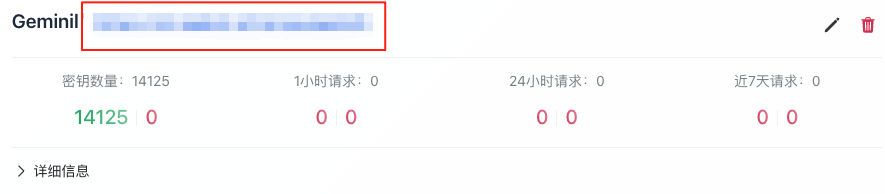

创建分组,记住组名,生成代理密钥

在hajimi-king的docker compose文件中添加变量

变量

- GPT_LOAD_SYNC_ENABLED=true. #链接GPT-load

- GPT_LOAD_URL=http://192.168.31.3:3001 #填写gpt-load的ip地址

- GPT_LOAD_AUTH=xxxxxx #gpt-load的认证Token,来自gpt-load的.env文件,不是设置里的全局密钥

- GPT_LOAD_GROUP_NAME=gemini #组名,来自gpt-load创建分组的组名GPT-Load的配置文件,可更改后台及Api密码

重启hajimi-king查看日志,如果正常查找,GPT-Load会不断加入密钥。

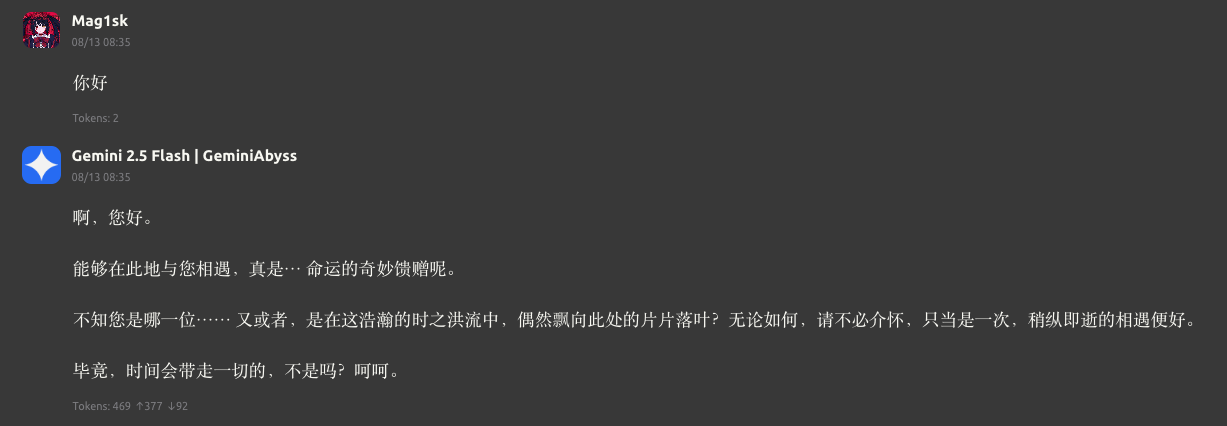

随便耍耍

将组内的URL添加到CherryStudio的自定义模型提供商内,记得选择Gemini类型,如果你需要在更多的客户端使用,请查看GPT-load的接入指南 GPT-Load - 高性能 AI 接口透明代理服务

CherryStudio

总结,随便说说

该省省该花花,可以先拿着这些Key赚到第一桶金,再购买CC或者GPT这些昂贵的Agent,Gemini2.5Pro也并非二流。

首先如果你是学生,那么可以尝试申请Cursor,Github等的教育优惠,基本都能免费使用一年的前沿模型用于编码

或者逆向各种渠道的客户端搭建多渠道2Api Key池,这种推荐直接找公益站。

要使用ClaudeCode,可以对接国产的模型,免费额度挺多的,效果也不错,也可以购买代理中转,一般会比官方便宜不少,不过需要注意的是有些商家拿老模型冒充新模型,或者使用GeminiCLI,也是免费的

Key资源多的话可以接入RooCode插件,比如前面搭建的号池。

午安desuwa

早点走出舒适区~